Contrôle du Perceptron

Visualisation

À propos du simulateur de perceptron

Ceci est un simulateur de perceptron simple, qui est le type le plus basique de réseau de neurones artificiels. Un perceptron est un classificateur binaire qui prend deux valeurs d'entrée, applique un ensemble de poids et un biais, et produit une classification de l'entrée comme appartenant à la Classe 1 ou à la Classe 2.

L'objectif du perceptron est de trouver les poids et le biais optimaux qui minimisent l'erreur totale dans la classification des points d'entrée. Vous pouvez ajuster les poids, le biais et le taux d'apprentissage à l'aide des curseurs de gauche, et ajouter de nouveaux points aux catégories Classe 1 (rouge) et Classe 2 (bleue) en cliquant et en faisant glisser sur le canvas.

Plus d'explication sur la classification

Lorsqu'on travaille avec deux caractéristiques en entrée, la frontière de décision est une ligne dans un plan bidimensionnel. Chaque côté de cette ligne correspond à l'une des classes. L'équation de la ligne est dérivée des poids assignés à ces caractéristiques et du biais. Elle peut être représentée mathématiquement comme suit : (w1⋅x1)+(w2⋅x2)+b=0 Ici, w1 et w2 sont les poids, x1 et x2 les caractéristiques en entrée, et b est le biais.

S'il y a trois caractéristiques en entrée, la frontière de décision devient un plan dans un espace tridimensionnel. Le perceptron utilise alors ces trois caractéristiques pour déterminer de quel côté du plan se situe un point d'entrée. L'équation de ce plan est : (w1⋅x1)+(w2⋅x2)+(w3⋅x3)+b=0 Dans cette équation, w3 et x3 représentent respectivement le poids et la valeur de la troisième caractéristique. Les points d'un côté du plan sont classés dans une catégorie, et ceux de l'autre côté dans une autre. Cette approche géométrique permet au perceptron de classer les points de données en fonction de leur position par rapport à la frontière de décision, qu'il s'agisse d'une ligne ou d'un plan. Au fur et à mesure que le nombre de dimensions (caractéristiques en entrée) augmente, cette frontière devient un hyperplan dans des espaces de dimensions supérieures.

Cependant, il est important de noter que, quel que soit le nombre de caractéristiques en entrée et la dimensionnalité de l'espace des caractéristiques, le perceptron reste un classificateur linéaire. Cela signifie qu'il ne peut classer que des données qui sont linéairement séparables. Dans les cas où les données ne sont pas linéairement séparables, un perceptron simple ne sera pas suffisant, et des modèles ou architectures plus complexes, comme des réseaux multicouches ou des classificateurs non linéaires, peuvent être nécessaires pour obtenir une classification précise.

Qu'est-ce qu'un perceptron ?

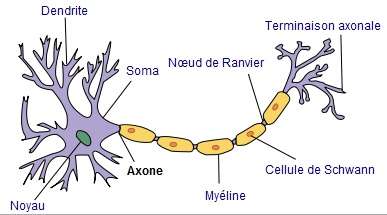

Le perceptron est une modélisation très simplifiée du

neurone. Ce dernier reçoit des signaux et émet, ou non,

un potentiel électrique en retour le long de l'axone.

Le perceptron n'est qu'une fonction qui s'active une

somme pondérée dépasse un certain seuil :